Apache Eagle, původně vyvinutý na eBay, poté darovaný nadaci Apache Software Foundation, vyplňuje velkou mezeru v zabezpečení dat, která zůstává řídce osídlená, ne-li holá: Vyčuchává možné problémy se zabezpečením a výkonem u velkých datových rámců.

K tomu používá Eagle další komponenty open source Apache, jako jsou Kafka, Spark a Storm, ke generování a analýze modelů strojového učení z dat o chování velkých datových klastrů.

Při pohledu zevnitř

Data pro Eagle mohou pocházet z protokolů aktivit pro různé zdroje dat (HDFS, Hive, MapR FS, Cassandra) nebo z metrik výkonu získaných přímo z rámců, jako je Spark. Data pak mohou být distribuována streamovacím frameworkem Kafka do detekčního systému v reálném čase, který je postaven na Apache Storm, nebo do tréninkového systému modelu postaveného na Apache Spark. První je pro generování výstrah a zpráv na základě stávajících zásad; posledně jmenovaný je pro vytváření modelů strojového učení k řízení nových zásad.

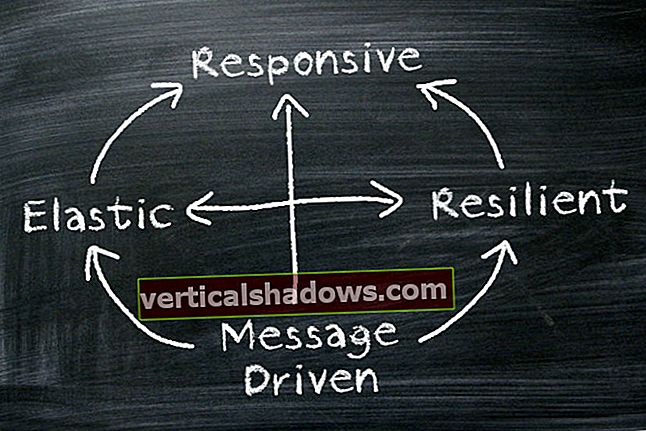

Tento důraz na chování v reálném čase převyšuje seznam „klíčových kvalit“ v dokumentaci pro Eagle. Za ním následuje „škálovatelnost“, „řízený metadata“ (což znamená, že změny zásad se nasazují automaticky při změně jejich metadat) a „rozšiřitelnost“. To poslední znamená, že zdroje dat, výstražné systémy a nástroje zásad používané společností Eagle jsou dodávány pluginy a nejsou omezeny na to, co je v krabici.

Protože Eagle byl sestaven ze stávajících částí světa Hadoop, má dvě teoretické výhody. Zaprvé, je tu menší reinstalace kola. Dva, ti, kteří již mají zkušenosti s dotyčnými kousky, budou mít nohu nahoru.

Co dělají moji lidé?

Kromě výše zmíněných případů použití, jako je analýza výkonu úlohy a monitorování anomálního chování, může Eagle také analyzovat chování uživatelů. Nejde o, řekněme, analýzu dat z webové aplikace, abychom se dozvěděli o veřejných uživatelích aplikace, ale spíše o samotných uživatelských rozhraních velkých dat - budování lidí a správu back-endu Hadoop nebo Spark. Je zahrnut příklad toho, jak spustit takovou analýzu, kterou lze nasadit tak, jak je, nebo upravit.

Eagle také umožňuje klasifikaci přístupu k aplikačním datům podle úrovní citlivosti. Tuto funkci mohou nyní využívat pouze aplikace HDFS, Hive a HBase, ale její interakce s nimi poskytuje model pro klasifikaci dalších zdrojů dat.

Mějme to pod kontrolou

Protože velké datové rámce jsou rychle se rozvíjející výtvory, bylo těžké kolem nich vybudovat spolehlivé zabezpečení. Předpokladem společnosti Eagle je, že může poskytovat analýzu založenou na zásadách a upozornění jako možný doplněk k dalším projektům, jako je Apache Ranger. Ranger poskytuje ověřování a řízení přístupu napříč Hadoop a souvisejícími technologiemi; Eagle vám dá určitou představu o tom, co lidé dělají, jakmile je dovnitř pustí.

Největší otázkou, která se vznáší nad budoucností Eagle - ano, dokonce i na začátku - je, do jaké míry ji prodejci Hadoop elegantně zavedou do svých stávajících distribucí nebo využijí své vlastní nabídky zabezpečení. Zabezpečení a správa dat jsou již dlouho jedním z chybějících kousků, kterým mohou konkurovat komerční nabídky.